-

资源简介

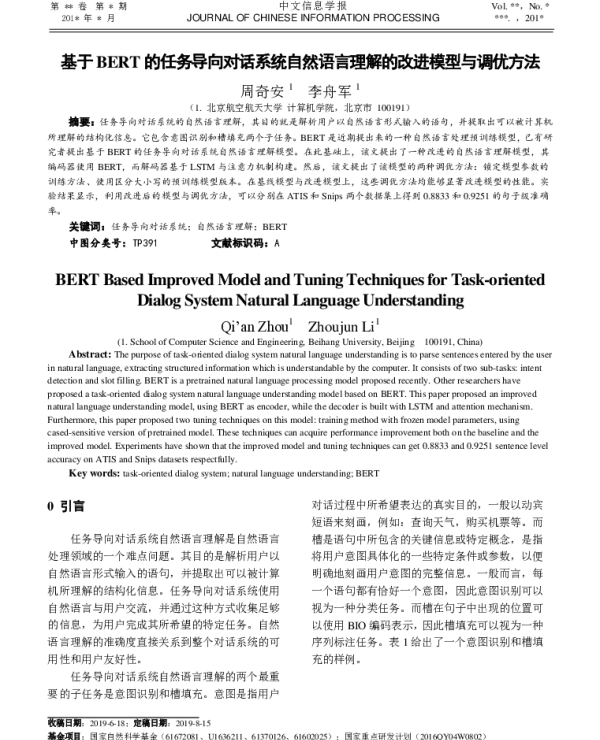

《基于BERT的任务导向对话系统自然语言理解的改进模型与调优方法》是一篇探讨如何利用预训练语言模型提升任务导向对话系统中自然语言理解能力的研究论文。随着人工智能技术的不断发展,任务导向对话系统在智能客服、语音助手等场景中得到了广泛应用。然而,传统的方法在处理复杂的语义和上下文信息时仍存在诸多不足,因此研究者们开始探索更高效的模型结构和优化策略。

该论文首先回顾了任务导向对话系统的相关研究,指出当前系统在自然语言理解(NLU)模块中的主要挑战。这些挑战包括对用户意图的准确识别、槽位填充的准确性以及上下文依赖的处理等问题。传统的基于规则或统计模型的方法在面对多样化的用户输入时表现不佳,难以适应复杂多变的对话场景。

针对这些问题,论文提出了一种基于BERT的改进模型。BERT作为一种强大的预训练语言模型,在各种自然语言处理任务中表现出色。作者通过引入BERT作为基础模型,并结合任务导向对话系统的特定需求,设计了一个更加适配的模型结构。该模型不仅保留了BERT强大的语言理解能力,还针对任务导向对话的特点进行了优化。

在模型改进方面,论文提出了多种创新方法。例如,作者设计了一种多任务学习框架,将意图识别和槽位填充任务结合起来,使模型能够更好地捕捉语义信息。此外,为了增强模型对上下文的理解能力,论文引入了注意力机制,使得模型能够动态关注对话历史中的关键信息。这些改进显著提升了模型在实际应用中的表现。

除了模型结构的改进,论文还探讨了模型调优的方法。作者分析了不同超参数对模型性能的影响,并提出了相应的调优策略。例如,通过调整学习率、批量大小和训练轮数等参数,可以有效提升模型的收敛速度和最终性能。此外,论文还讨论了数据增强和迁移学习等方法,以进一步提高模型的泛化能力和适应性。

为了验证所提出方法的有效性,论文在多个公开数据集上进行了实验。实验结果表明,改进后的模型在意图识别和槽位填充任务上的准确率均高于基线模型。特别是在处理长对话和复杂语境的情况下,改进模型表现出更强的鲁棒性和稳定性。这些结果证明了所提方法在实际任务导向对话系统中的可行性。

此外,论文还对模型的可解释性进行了分析。通过对模型内部的注意力权重进行可视化,作者发现模型能够有效地捕捉到与任务相关的关键词和语义信息。这不仅有助于理解模型的工作原理,也为后续的模型优化提供了重要的参考。

总体而言,《基于BERT的任务导向对话系统自然语言理解的改进模型与调优方法》为任务导向对话系统的研究提供了一个新的方向。通过结合BERT的强大语言理解能力,并针对任务需求进行优化,该研究为提升对话系统的自然语言理解能力提供了有效的解决方案。未来,随着深度学习技术的不断进步,这一领域的研究将继续深入,为构建更加智能和高效的对话系统奠定坚实的基础。

-

封面预览

-

下载说明

预览图若存在模糊、缺失、乱码、空白等现象,仅为图片呈现问题,不影响文档的下载及阅读体验。

当文档总页数显著少于常规篇幅时,建议审慎下载。

资源简介仅为单方陈述,其信息维度可能存在局限,供参考时需结合实际情况综合研判。

如遇下载中断、文件损坏或链接失效,可提交错误报告,客服将予以及时处理。